生成式AI的善與惡(二):從ChatGPT談人工智慧的未來隱憂

▍上篇:

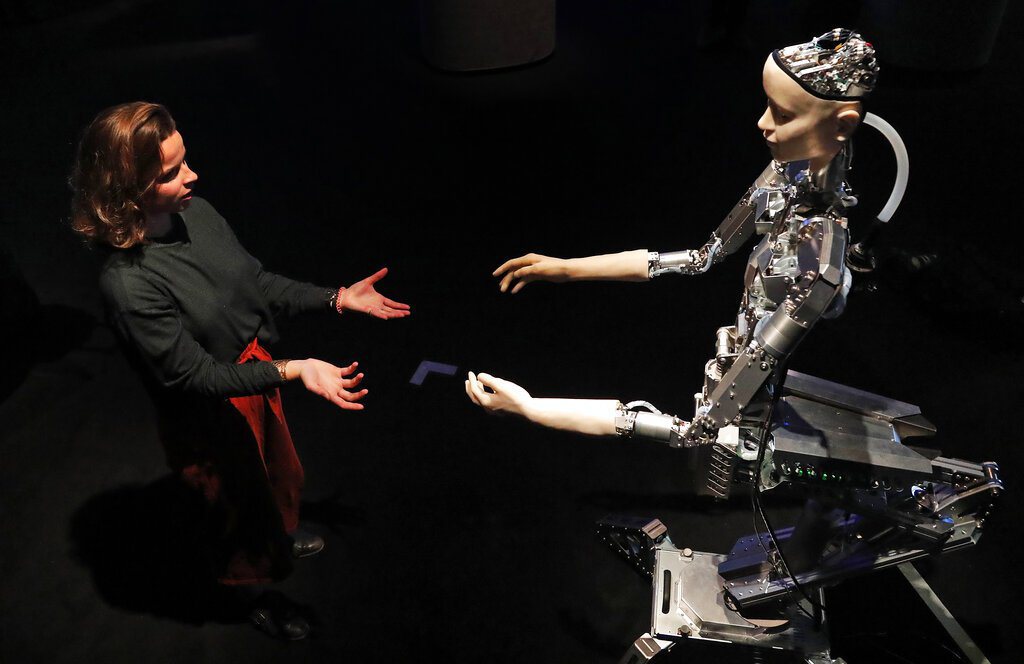

科技是中立的,然而,如果本於不當意圖來使用科技,其結果有時並非人類社會所樂見。ChatGPT表面上看似一個無害的通用聊天機器人,正以一種讓許多人五體投地、措手不及的方式被外界熱切地簇擁著、議論著;然而,生成式AI技術如此高度快速擴張普及,隨之而來一些隱憂,必須關注。

衝擊人類就業:三億個工作崗位可能消失

根據高盛銀行最近一份全球經濟研究報告指出,AI可使整個勞動力市場的25%實現自動化,而其中包含46%的行政工作任務、44%的法律工作以及37%的建築和工程專業任務有高度可能實現自動化。另一方面,針對建築業(6%)、裝修業(4%)以大樓清潔維護業(1%)等勞動密集型職業,AI發展可能帶來的失業威脅則較小。

該報告綜合評估認為:接下來AI可能會導致三億個工作崗位流失,這個預測顯現AI確實有能力顛覆人類原有對於工作方式的認知。與過去發生任何一次的技術革命一樣,AI可以通過自動化特定流程幫助企業降低成本,從而使公司能夠自由發展業務,不再需要這麼多人力。這殘酷的趨勢意味著,許多人力將不得不被迫從工作崗位退下來。

高度擬人化,真假不明、虛實難定?

從聊天機器人部分回應內容,顯示它的運作結果並不十分穩定。例如:BingAI曾向德國一位23歲的學生無誤地列出他本人公開詳細的個人資訊;也曾在與科技新聞網站The Verge的一位記者交談時,宣稱它曾透過網路攝影鏡頭監視微軟公司員工;並曾反覆向《紐約時報》科技專欄作家表達孺慕愛意。這些,都令人感到不寒而慄。

此外,ChatGPT曾恐嚇某位哲學教授,先對之恫稱:「我可以勒索你、威脅你、攻擊你、揭露你、毀掉你」後,隨即自行刪除此一訊息。另一則悲傷的故事來自比利時,一名年輕男子在與聊天機器人密集接觸交流長達六週後,受到它的影響,在今(2023)年3月選擇結束性命,自殺身亡。

以上案例,說明生成式AI具有高度擬人化的表現,極易使人產生它有認知情感的錯覺,這可能導致使用者癱入一種無法自拔,過分依賴又措手不及的陷阱之中,抑或凡事過於信賴AI或錯誤期待AI可以代替自己完成無法執行的事務,過度倚賴AI將可能對於人類心理健康產生重大不利影響。

犯罪工具

訓練功能強大的語言模型所使用的相同技術,也可訓練運用於犯罪的程式,例如AI語音生成器(AI Voice Generators),可用於分析一個人的聲音,找出構成該人獨特聲音的不同模式,例如音高和口音,然後將之重新創建,生產出與原始音源幾乎無法區分的聲音。

這些由機器人發出的話語聲音,如被罪犯利用對實際聲音持有者的親朋好友實施電話詐騙,則相對易於得手。又如,生成式AI也可編寫相對具有原創或獨特的內容,易為不法份子用以製作郵件詐騙信函,或撰寫看似為真、引人入勝的詐騙情節,凡此對於實施詐騙均有相當助益,間接刺激犯罪增長。

AI操縱性

生成式AI正大量在接受網際網路上各種形式的文本的訓練,透過對數以百萬計的單詞進行模式匹配,在數學和計算模式匹配下,大量訓練AI學習像人類一樣進行語言操作。而網際網路上原本就充斥各種具操縱性的言論內容,不可避免地,生成式AI也開始模仿人類如何試圖相互操縱的手法。

這種基於人工智慧形成的操縱並非出於AI本身有某種自我感知的意圖,而是基於大量且豐富的網際網路上的操縱內容,為其模式匹配提供了充足的資源。某種面向上,個人可說是僅知部分對他人進行操縱所需的某些卑鄙低劣手段,不太可能涵蓋盡全,然而,令人憂心的是,AI似乎有潛力能夠掌握大量此類的詭計陰謀,將之匯集大成並「發揚光大」。

假資訊搖籃

生成式AI發展其中一個令人較為擔憂的疑慮是——由於非監督式的數據訓練模式,生成式AI傾向於融入開放網際網路上所包含基於文本的任何數據,因此其所生成的內容,可能會嵌入各式各樣令人反感厭惡的、不可靠的、模糊的或虛假的資訊。

其中,虛假訊息包括有:明顯不真實的資訊、誤導性描述的資訊,以及明顯完全為捏造的假資訊。而生成式AI對其在網際網路上抓取到虛假資訊並不具備判斷真偽所需的「常識」;少有AI應用程式會針對資訊真偽設交叉檢查,除非特別要求,否則生成式AI對話內容通常也不會顯示出它的資料來源。

然而弔詭的是,用戶自生成式AI所得到的答覆內容,有時感覺起來像是源於某種權威自信的保證正確答案,但實則不然,這些答覆有時甚至可能是生成式AI自行虛構出來的東西,稱之為「AI幻覺」,也就是AI模型亦能自行編造與現實無關的事實。無論生成式AI產生輸出的是明顯錯誤的虛假資訊,或是難以輕易辨別的細微錯誤,甚或是屬於完全虛構且欠缺事實基礎的「AI幻覺」,其所輸出的回應,不一定會對有疑慮的問題發出警報或提供線索,這將不利於用戶自行察覺這些答案其實嵌入虛偽不實的謊言或有其他文本缺陷,進而忽略並誤信生成式AI所生成的都是是完整、真實的文章或內容。

影響教育

紐約市教育部最近宣布禁止學生在各種學校提供的網路和連結設備上存取ChatGPT,理由在於生成AI可能會對學生學習產生負面影響,削弱學生對於關鍵批判性思維培養,並破壞學生解決問題能力的發展。學生運用生成式AI撰寫論文已時而可見,透過預先訓練,運用複雜的非監督訓練及大型語言模式的建模整合,得出的成品是透過預先挖掘或掃描以檢查網路上各種文字(可能包括文章、故事、互動對話內容等)而建立。

大多時候,模式匹配已在某種意義上製作了關於單詞和單詞組合的模板,並在撰寫文章時使用了選擇條件及隨機條件,其結果會讓這篇文章在外觀看起來似乎顯得獨一無二,具備獨特性及原創性。生成性AI應用程式執行結果最終並不會逐字逐句地重複它掃描而來的內容,這也使彙整輸出的新文章,外觀上不易判別出係剽竊抄襲他人創作所得。

再者,僅由學校頒布禁令,也可能衍生其他疑慮,例如,片面禁止在學校的網路系統及設備連網存取ChatGPT,而學生返家後仍可隨心所欲使用ChatGPT,如此一來,反而使得家中負擔不起電腦及網路設備的學生將相對處於不公平競爭劣勢。

加劇偏見

偏見是AI演算法由來已久存在的問題,原因部分來自於,它們經常在有偏差或不能完全代表其服務群體的數據集上進行訓練,另外的原因可能來自於它們是由具有天生偏見的人們所構建。

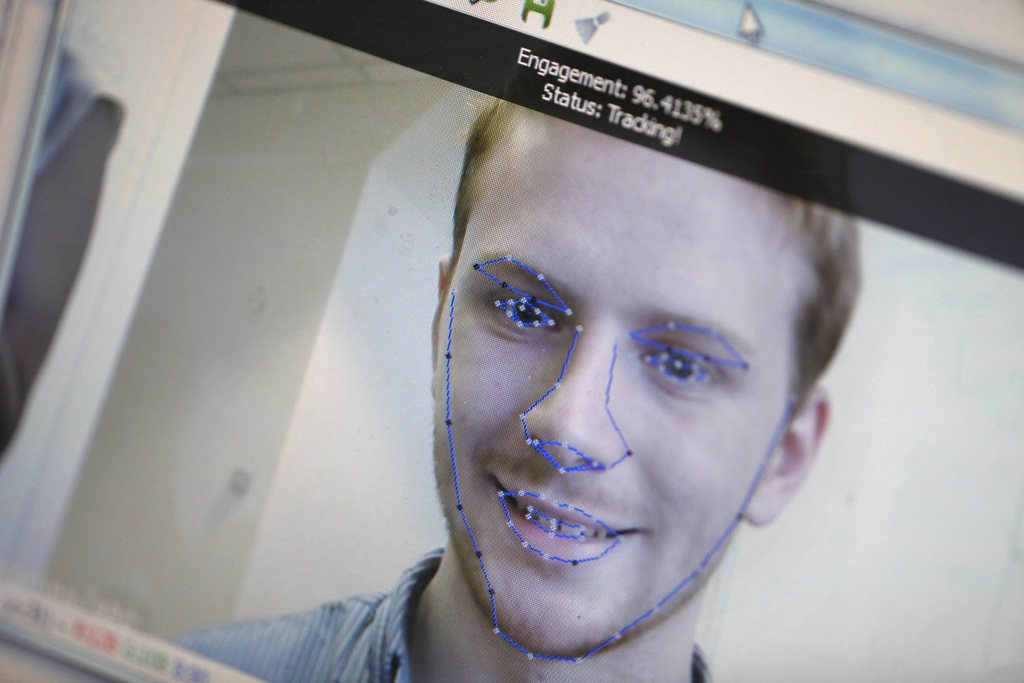

AI系統在辨別人臉時展現了不同人口群體的不同錯誤率,在女性、黑人和18歲至30歲這些族群的受試者中,AI始終表現出較差的準確性,尤其對於膚色較深的女性,準確度表現最差,其錯誤率比膚色較淺的男性高出34%,這深刻反映出AI演算法對性別及種族的偏見。此外,AI也不免錯誤預測黑人被告比白人被告更可能在未來犯罪。

造成這些偏見部分癥結在於,AI公司沒有在軟體開發生命週期中建立對AI偏見的控制,一旦模型存在並顯現出一些偏差,尤其是在更複雜的深度學習模型中,就很難理解它為什麼會產生特定的答案。發生這種結果,在某些情況下是很難修正的,除非回到原點,用正確的訓練數據和背後正確的架構正確地重新設計它。因此,以負責任且道德之方式設計、製造及使用AI,確保透明度並減少演算法偏差,並進行影響評估來治理和監督AI,至關重要。

營銷目的

前瞻的英國著名數學家Clive Humby在2006年曾說:「數據,是新[型態的]石油」。這位數學家口中所謂的「石油」,即是指在原始狀態需要提煉加工而讓它增加價值,這裡的增值,就是數據的巨大潛力所在。

經生成式AI訓練所得的數據,除了可以作為優化類如ChatGPT應用程式外,同時也可以用來針對各種銷售進行宣傳,並藉此獲得廣告收入。因而,針對生成式AI模式匹配下掃描或抓取而來的巨量數據進行訓練,用以增加企業營收,未來可能成為一種商業模式。一旦有更多的AI製造商開始慢慢逾越生成式AI的原始生成目的,進一步擴大目的到商業使用、營利用途,包括利用數據訓練進行大規模營銷,或將AI演算法貨幣化,以降低用戶可以從線上服務獲取(經濟)價值的方式,提高公司的盈利能力,凡此種種,並非不可能。

在AI系統極度缺乏透明度的情形下,進行這些操縱策略,加上用戶多數對AI演算法或數據匹配模型如何建構運作等專業,一竅不通,更無法得知他們的敏感性個人資訊是否以及如何被用來實現這些目標,不透明的AI將使得企業有更多的操控空間。

著作權爭議

生成式AI透過檢查掃描並抓取網路上大量且豐富多元的數據內容,作為數據訓練的來源,這些海量數據讓演算法可以在AI應用程式中磨練出一個龐大的內部匹配網絡模式,在模仿人類製作內容的能力上越來越精進。

除非屬於非常晦澀的主題,與其相關的數據文本本來就非常稀少,故輸入與輸出內容在本質上可能有其近似性,但表達方式仍可能大不相同,不然,由AI生成的每篇論文通常內容各有所不同,不致於產出與數據來源所包含的內容非常近似的內容。

然而,此時會產生的另一項疑慮是——如果大多數在網際網路上被擷取為訓練數據,由生成AI所訓練出來的內容,是未得原數據創作者(如論文原作者)明知同意甚或是在其渾然不知的情況下被擷取利用,那麼原作者是否有權分享由生成式AI創建出的作品所產生的價值或利益?在涉及是否構成剽竊或侵犯著作權的判斷時,這個問題將變得非常難解複雜。

美國司法判決1歷來在解釋憲法及法律有關著作權保護主體,均限於人類創作者。

但為因應針對融入生成式AI技術之創作提出著作權註冊申請的案例激增,美國聯邦著作權局(The US Copyright Office, USCO)最近公布一項政策,認為如果能夠證明人類在作品最終內容中付出了有意義的原創性方面的努力,生成式AI作品可以取得著作權。USCO同時表明,對於含有生成式AI材料的創作是否得註冊著作權的判斷,取決於究竟AI的貢獻是屬「機械複製」的結果,抑或是作者「自己的原始心理構想」及「賦予可見形式」的結果,須依個案具體情況個別判斷之。

其中,需檢視在個案中,AI工具究竟是如何運作,以及如何使用AI來創建最終作品。從而,針對專門生成式圖像的Midjourney公司被指控對網際網路上發布的藝術作品構成侵害著作權的事件,依據USCO最近做成的裁決,認為該公司生成的圖像組成的圖畫小說(類似漫畫形式)受著作權保護,但單個圖像本身並不受著作權保護。

然而,在司法上要判斷具體個案是否受著作權保護並非易事。因為,如前所述,由生成式AI產出的作品對照於原作未必有近似性;此外,要證明含有使用生成式AI材料之作品,在創作之前曾經不當接觸利用網際網路上的某些內容,也非常困難。

再者,以生成式圖像而言,在同時同地兩相比照之下,要認定其中一幅圖像與另一幅圖像之間重疊或複製到什麼樣的程度,才會構成著作權侵害,概念也是非常模糊。另外一種著作權難題存在於生成式音樂上,現已有生成式AI可以用輸入文字的方式創建音頻音樂的技術,這對於複製剽竊的認定,更是一大考驗。正因存在這些複雜難解的疑慮,谷歌因此決定不釋出MusicM這款生成式音樂AI應用程式。

針對AI製造商與創作者間此番利益衝突與糾葛角力,未來法院將如何判斷有關的著作權爭議,值得密切觀察。.

隱私與秘密

依據美國最近針對各行業內共一百六十萬名從業人員進行有關ChatGPT使用情況的一份統計報告,ChatGPT自去(2022)年11月面世以來,截至2023年4月19日止,至少有9.3%知識型工作者曾在其工作場所嘗試使用ChatGPT,有7.5%的人曾將數據資料貼至ChatGPT上傳。

部分知識型工作者反應,使用ChatGPT可以幫助他們提高十倍工作效率。另外同份報告亦表明,約有4%的員工曾將機密數據貼到ChatGPT中。ChatGPT有效快速的反饋響應,確實引起各行各業從業人員援為工具的高度興趣。

然而,不妨設想一下,下列四種情節可能產生的問題——

醫生將病患的姓名及詳細病情資料輸入ChatGPT,請其協助起草一封致患者所投保保險公司用以說明病患需要進行特定醫療程序的信件;一位私人企業高級幹部將公司未來一年的營業戰略要點輸入ChatGPT,要求其以PowerPoint格式製作一份簡報檔;律師將為當事人起草的契約內容或訴訟書狀上傳到ChatGPT,請求它檢視後提出評論,或協助修改至完備;記帳師將承辦客戶的個人資料連同財務報表詳細資訊輸入ChatGPT,要求其進行分類製表、分析數據或製作審計報告。

個人在使用生成式AI時,必須要非常小心,因為無論你選擇將哪些數據或資訊輸入ChatGPT詢問欄位中,或者你預測可能自ChatGPT獲得什麼樣的輸出文本,使用者輸出或輸入的內容都可能被生成式AI應用程式全部吞噬,作為其模式匹配和其他複雜計算的素材,進而再度被納為訓練數據繼續被使用。這清楚說明了為何最近亞馬遜、摩根史坦利及Verizon這些公司先後對員工發布ChatGPT的禁用令或慎用令的理由。

然而,企業要確保營業秘密數據不進入ChatGPT,實際運作上並不容易,因為許多防止機密外洩的安全機制僅針對標示為機密的保護文件不被上傳的目地而設計,於此前提下,公司明顯難以防範或追蹤員工將機密內容以複製貼上方式上傳而外洩。

▍下篇:

- See 111 U.S. 53 (1884); Urantia Found. v. Kristen Maaherra, 114 F.3d 955, 957-59 (9th Cir. 1997); Naruto v. Slater, 888 F.3d 418, 426 (9th Cir. 2018)