人工智慧是人嗎?從Google的LaMDA談如何與「牠」共存

近日,一名Google工程師於內容平台medium上,公開其參與的人工智慧軟體「LaMDA」的對話紀錄,聲稱其有認知能力,具有「人格化」的條件,引起熱議。「人工智慧取代人類」的爭議再度被拿出來討論。

從技術的進程看來,一般認為在未來十至三十年人工智慧的確有可能發展成具有獨立思考能力與人格的「強人工智慧」。本文暫不評論現階段Google研發的「LaMDA」是否已進階至此,但既然技術的演進未曾停歇,我們社會勢必需要全體公民共同思考在人工智慧機器人時代,要如何與「牠們」共處。

阿西莫夫的機器人三法則

在人工智慧機器人倫理的討論中,於1942年由科幻小說家以薩.阿西莫夫(Issac Asimov)提出的機器人三法則時常被拿出來討論,這三法則亦可說是機器人倫理學的濫觴,分別為:

- 機器人不可以主動傷害人類或被動地坐視人類受到傷害。

- 機器人必須服從人類命令,除非該命令與第一法則發生衝突。

- 在不違背第一或第二法則之下,機器人需保護自己。

在阿西莫夫的科幻小說裡,這三法則是在他那充滿驚奇與想像力的架空未來世界中,人工智慧工程師植入所有機器人產品的演算法邏輯。

然而,真實世界的狀況要複雜得多,阿西莫夫的機器人三法則過於模糊,遠遠無法應對21世紀的機器人監管與治理需要。因此,近年隨著人工智慧的應用場景增加,逐漸有學者提出更加明確的人工智慧機器人法則。

新機器人法則

本文想介紹由美國馬里蘭大學Frank Pasquale教授統整、發展出的「新機器人法則」(New Laws of Robotics),當中有許多觀念已被歐盟最新的「人工智慧法草案」(全名:「人工智慧法律調和規則」;英文:Regulation of the European parliament and of the council laying down harmonised rules on artificial intelligence (artificial intelligence act) and amending certain union legislative acts)採用:

1. 機器人與人工智慧應作為專業人員的輔助工具,而不是為了取代專業

這一則法則強調區分專長(expertise)與專業精神(professionalism),前者是完成職責任務的能力;後者則是再加上處理衝突,或是進行價值選擇等人性化觀點的工作內容。人工智慧機器人應不可完全取代人類完成需要專業精神之工作。

人工智慧機器人可以做的,是代替人類從事危險或是「低人性」(degrading)的工作,例如拆除爆裂物、流水生產線產品組裝等。此外,人工智慧作為專業人員的輔助工具,應該要確保工作者從中得到價值感、成就感與公平的報酬。

然而,機器人可取代/不可取代何種工作需要全體社會進行更多價值辯論。「專業精神」或是「低人性」的界定過程,需要讓勞工能夠在生產組織上有一定的發言權,同時賦予勞工促進共同利益的責任,以及對抗監控與資料蒐集的力量。

2. 機器人與人工智慧不應該假冒人類與人性

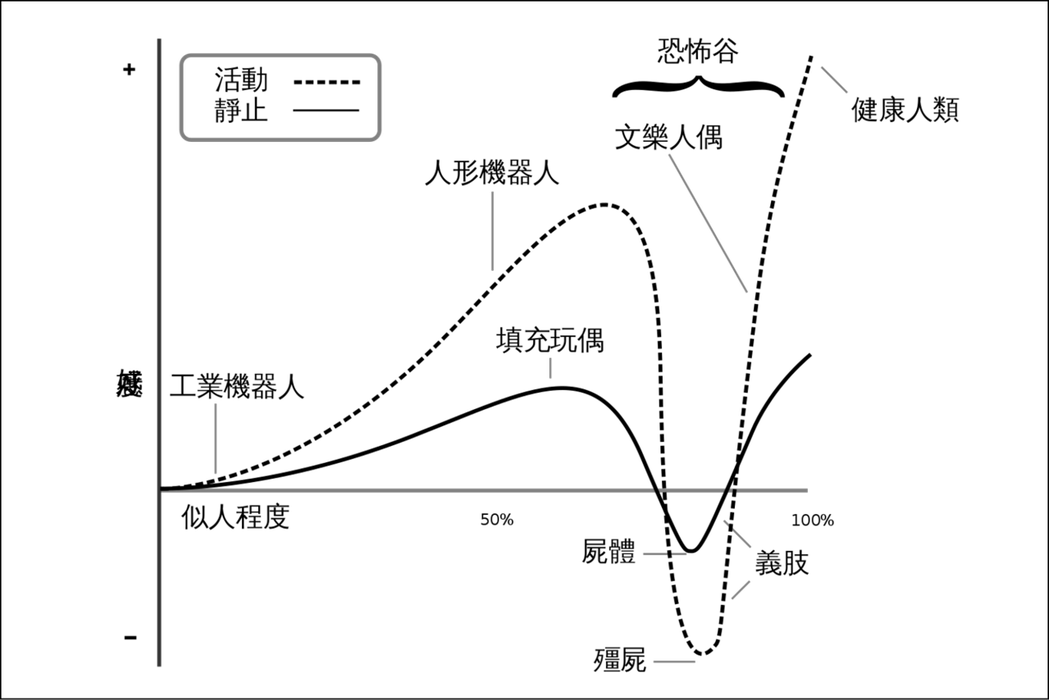

大家不知是否覺得小丑的妝容令人恐懼,或是覺得人偶娃娃令人害怕?根據心理學的恐怖谷理論(Uncanny Valley),這是源自於人類天生就會對於「非常像人類,但又覺得它不是人類」的事物感到懼怕。

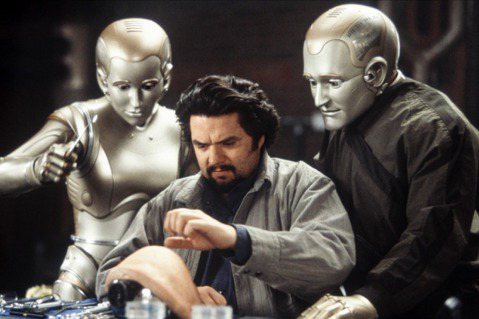

早期,機器人產品有許多設計成具有很像人類的臉部,因而備受爭議。因此近年許多機器人產品公司索性將機器人設計成動物。例如設計成可愛海豹的聊天機器人PARO、設計成白熊的照護搬運機器人Robear。

除了機器人外觀不應像人,無結合機械的單純人工智慧軟體,特別是具有情感運算功能的人工智慧,亦不可「躲」在螢幕的另一端,假冒牠自己是人。這是因為假冒人性不僅具有欺騙性,同時使造假者(軟體開發商)受益於虛偽的情感投資,對於消費者不公平。

另外,亦有論者擔心,如果讓人工智慧模仿人類的語言與情感,與人互動,會讓真實的人與人之間的情感交流迅速貶值,此後人類的情感需求將成為一種消費市場,由軟體開發公司進行滿足,且由於資本逐利的特性,將加速社會人際關係疏離,導致更多社會與個人的心理問題。

是以,包含Pasquale教授在內的許多科技倫理學者,都支持立法避免人類使用者不知道面前與之互動的對象是機器人或人工智慧。這一主張也在歐盟人工智慧草案第52條有關人工智慧透明化義務(transparency obligations)的規範中體現。

3. 機器人與人工智慧需表明其創建者、控制者和所有者的身分,使其對於產品負有相應的責任

這一法則強調機器人與演算法實施的結果,需由人類負責。即便是深度學習甚至是「失控」的機器人,都應有對應的實體或自然人對之負責,必要時負擔損害賠償責任。

演算法實施的結果可能有多個潛在的責任方,但創建者有責任在演算法當中設定一些限制,避免其產生出不良的結果。例如,微軟前幾年推出的聊天機器人Tay,透過與推特網友的互動進行學習,最終被網友「教」成種族主義納粹分子。

在此法則下,微軟應在演算法中安插把關機制,避免產生不當言論。同時,監管機構應要求開發商負擔包含資訊安全與隱私保護之設計責任。

從現在開始重視人工智慧機器人的監管法規與政策

許多技術支持者會主張「科技先行、管制置後」,或是「管制會阻礙科技發展」,筆者無法全然同意。原因在於,其一,當機器人、人工智慧演算法被投入實驗室或研發中心封閉網絡以外的地方應用,就開始影響社會運作。而人工智慧的發展涉及價值選擇問題,不是單純的經濟成本與技術問題,需要社會共同參與。

其二,面對人工智慧技術快速發展,「等等、再看看」(Wait-and-see)的監管態度不可取,因為科技無時無刻在重塑社會價值,永遠不會有「合適的」監管時點。當人工智慧與機器人進入監管的領域,可使我們有機會藉此透過政策或立法,塑造合乎隱私與消保規範的機器人準則,甚至透過法規引導技術往符合社會期待的方向發展。

最後,人工智慧、機器人議題不單純只是科技政策,而是跨領域議題。機器人與人工智慧的部屬涉及多重體系的改革與規範(例如,自駕車上路需配合道路基礎建設更新),在此狀況下,在地知識與跨領域知識的重要性將更甚以往,若能及早將人工智慧管理擺上檯面成為國家重要政治議程之一,可有助技術的正向發展,讓技術與在地文化價值調和,使科技真正發揮其促進人類社會幸福的效果。