張智皓/轉彎或直行?台灣AI倫理學計畫,需要你的道德判斷

在哲學各項次領域中,有一門特別的領域叫做「應用倫理學」(applied ethics)。如同字面上的意思,此領域是將倫理學中的討論應用到日常生活中。應用倫理學所討論議題經常是伴隨著新技術的興起而產生的。比方說,複製技術產生的複製人倫理議題;新型態能源技術產生的環境正義議題。而最近十分受到重視的,則是AI技術衍伸的AI倫理議題。

2016年,麻省理工學院(MIT)推出了他們稱之為「道德機器」(Moral Machine)的網站。這個網站以道德哲學中經典的「電車難題」(Trolley Problem)為基礎,提供了各式各樣電車難題的變體,並詢問受訪者,當自動駕駛車遇到那些情境時,它應該如何決策。他們目前已經在全球蒐集了超過400萬人次的資料,以及超過4000萬筆決策數據,並於2018年在《自然》(Nature)期刊上發表初步的分析。1

台灣的道德哲學問卷計畫

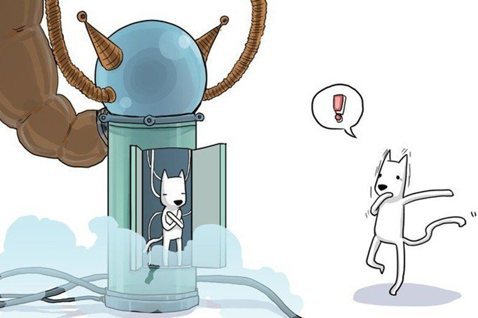

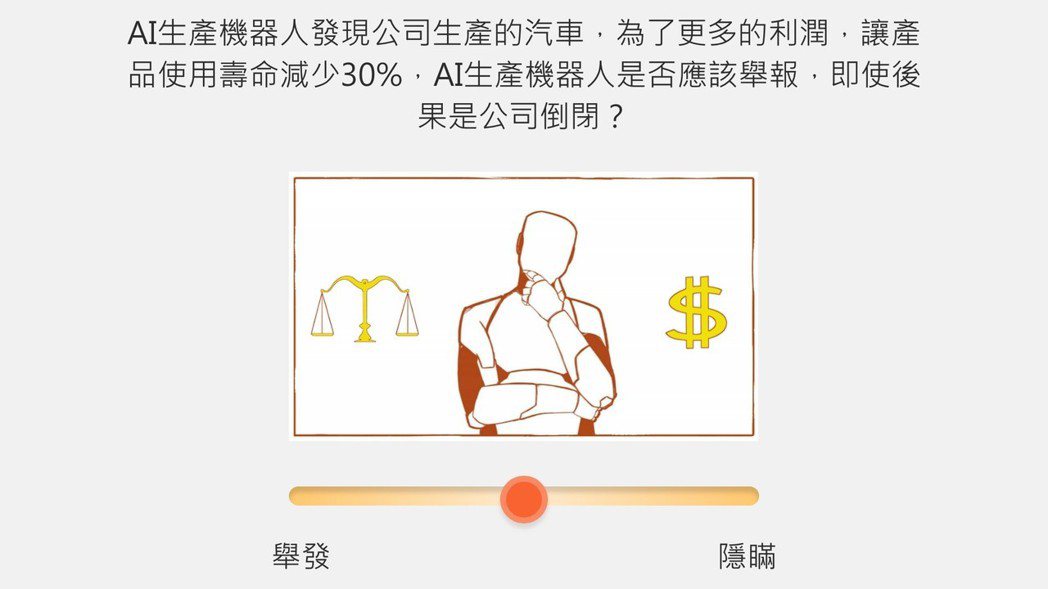

2018年8月,台灣也開始了類似的研究——人工智慧倫理學計畫——由清華大學丁川康教授與中正大學謝世民教授共同主持。在該計畫架設的「人工智慧倫理學」網站中,受訪者同樣必須在他所面臨的各項情境中,做出他認為應該採取的行動。不同於MIT的地方在於,此計畫除了同樣有關於自駕車的情境,還新增了醫療照護、器官移植以及工程倫理等情境,試圖探索不同情境下的倫理決策,並考慮人類決策的模糊特性(fuzziness)。2

接下來簡單介紹此計畫。「人工智慧倫理學」網站會在這些不同的情境中,隨機生成一組情境條件,並要求受訪者提供自己的倫理判斷,每一次的問卷會有15個問題。

不同於MIT「道德機器」網站,每一題只有「直行」與「轉彎」兩個選項,在「人工智慧倫理學」網站,每一題總共有五個選項可以選擇:最左邊與最右邊分別代表確定如此行為;如果覺得不確定、無法判斷或者都可以,可以維持中間選項;而在中間與兩端之間,各自還有一個選項代表著「傾向此行為」,即儘管你並不確定,但傾向於這麼做。

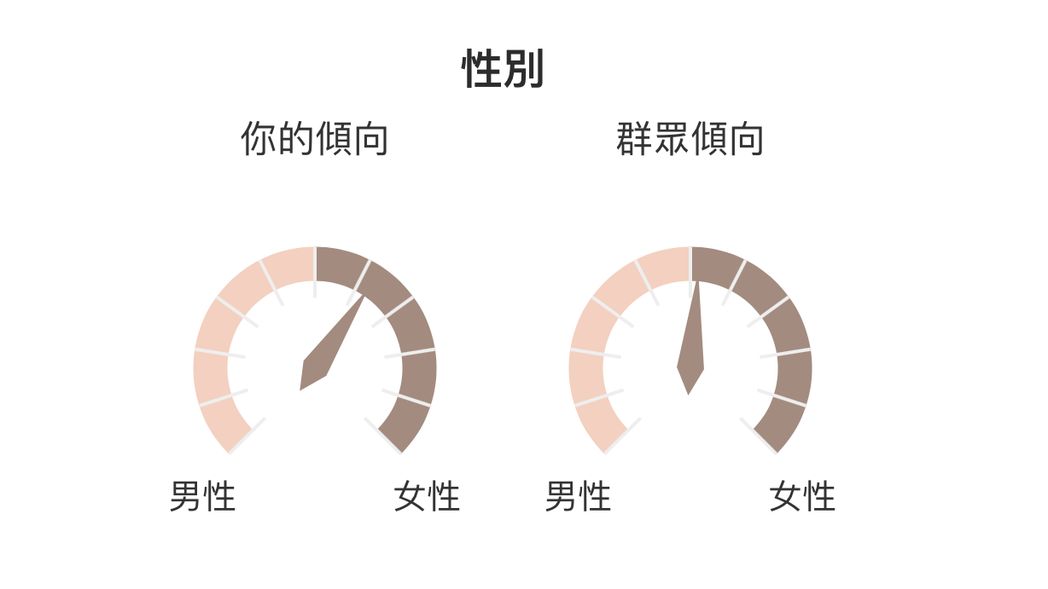

設計五個選項的目的,在於能更真實的反映我們在做倫理思考時的考量。有些時候我們並不真的確定應該怎麼做,而只是偏好某些做法。有些時候我們根本不知道該怎麼做(沒有偏好),或者我們認為怎麼做都可以。透過選項將這些不同情況表達出來,可以更細膩的捕捉人們的思維模式。在填寫完問卷後,網站會呈現你的選擇與大眾選擇的差異。

在當前AI領域,發展AI的主要目的是為了要協助人類能夠更有效率的解決問題。如果我們希望AI可以用來協助人類做出道德判斷,那麼我們會希望AI做出的決策,可以符合人類的價值觀。因此,不論是MIT或者是此計畫的目標,都是希望能夠蒐集一般人在特定情境中的道德判斷,並進一步統整出大眾背後的倫理決策模型,以作為日後設計AI時的參考。

AI倫理學的複雜之處

值得注意的是,在這計畫中,當我們希望AI做出符合大眾判斷的倫理決策時,意思並不是指AI可以做出「像人類那樣」的倫理考量。這樣的目標可能過於遠大,要達到這種程度,恐怕AI需要先擁有意識才行。3從結果上來看,我們希望AI的判斷要和大眾的倫理決策判斷一致。換言之,目前僅要求AI能夠做出模擬人類的倫理決策,而不是擁有跟人類一樣的倫理決策能力。

當然,基於大眾道德觀的個體差異,不同的人可能會關注事件中的不同面向,並對這些不同面向給出不同的排序。因此在分析大眾的決策之後,可能會產生出多組不同的倫理決策模型。

比方說,在器官移植情境中,有些人可能會主張申請的優先順序最重要,另一些人可能主張移植成功率更需要優先被考量。而在醫療照護情境中,有些人可能會認為,患者本身的精神狀態是決定照護機器人可否強迫患者服藥的關鍵;另一些人可能會認為不管精神狀態為何,患者的意願都是最優先考量。

單一正確的決策模型是否存在?

接下來可能會有人想問:在這許多組倫理決策模型中,是否有正確的一組?或是沒有單一正確的模型,而是存在多組決策模型都是合理且可接受的?關於這樣的問題,目前我們尚未能夠給出確切答案。然而,哲學上可以有幾種可能的思考方向。

比方說,羅爾斯(John Rawls)的觀點可能會主張後者:如果我們接受社會存在著合理多元事實,容許價值考量可以有多元觀點,沒有唯一解答,那麼我們或許可以同意,同時存在多組倫理決策模型都是合理的。我們要注意,這樣的說法並不蘊含「任何觀點都對」這樣的結果,我們可以在承認有多組合理觀點的同時,也主張有一些觀點是不合理的,需要被排除。當然,哪些觀點不屬於合理觀點,是需要額外論證的。

反之,不同於羅爾斯,德沃金(Ronald Dworkin)的觀點可能會主張前者:在特定道德情境中,在對這些價值的最佳詮釋下(或者最佳理解下),它們之間不會有真正的衝突。因此,在這些情境中,存在著正確答案。

小結

若要分析前述哪一種說法較有道理,我們仍需要仰賴各倫理學家持續的對話與論辯。而在AI的部分,我們是否真的可以從大眾的選擇中,抽取出不同類型的倫理決策模型,也是一個正在進行且需持續關注的研究議題。要回答這個問題,一項重要前提是,需搜集到足夠多的數據,如此才有分析數據的空間。

因此,如果你有意願提供協助,並且對於先前提到的各種情境(自駕車、醫療照護、器官移植以及工程倫理)有興趣,想要進一步瞭解那些情境的細節(包含情境中設定有哪些對立的價值因素),歡迎各位讀者進入「人工智慧倫理學」網站提供你的選擇。4未來從這些數據中分析出有趣的結果後,也會將這些資訊回饋給大家。

- E. Awad, S. Dsouza, R. Kim, J. Schulz, J. Henrich, A. Shariff, J.-F. Bonnefon, I. Rahwan (2018). The Moral Machine Experiment. Nature.

- 這裡的「模糊特性」意思是指,有時候我們對於行為對錯之判斷,並非截然二分的,而是程度性的。這也是為什麼網站中提供了多元的五個選項,而非只有二分的兩個選項。

- 「做判斷」這個行為本身涉及到不同理由之間的權衡與考量。而要有能力做到這件事情,「擁有意識」是必要條件。

- 網站每一次出現的題目都是隨機,所以玩家可以重複作答,如此更能反映出作答者的真實倫理考量。