葉多涵/目前的人工智慧真的不可能有心靈嗎?

在你面前有一隻普通的智慧型手機,它可以做很多很厲害的事情,例如在幫你找路、連絡你要找的人、跟你玩遊戲、記錄眼前的景象、播音樂給你聽……或是讀這篇文章。在古代,同樣的事情必須由人類來做:你必須找人問路、請郵差送信、跟別人對弈、找畫家畫下景物、找音樂家來演奏……或是讓送報童把這篇文章送到你手上。但是我們不會說智慧型手機擁有人類的智能和自我意識。

為什麼?原因之一是人類知道手機裡面的每一條電路、每一個晶片、每一行程式碼是如何運作的。手機只是基於我們設計出的結構、基於半導體和電流的物理定律在運作,就好像機械錶會顯示時間只是因為齒輪的運轉,電鍋會跳起來只是因為溫度影響磁性。

如果有一天,腦科學家弄清了人腦中的每一條神經怎麼運作,能分析和預測整顆大腦在受到各種刺激時會作出什麼反應,這是否表示人腦也沒什麼特別,只是一團比較複雜的齒輪?這並非不可能;自然界有不少生物已經被生物學家摸得相當透徹。我們知道大腸䏷菌、阿拉伯芥、線蟲、果蠅等生物大致上是怎麼運作的,如何從基因到蛋白質到細胞到型態和行為。

在神經訊號傳遞過程中,人腦如何出現意識和感知?從機制來說,許多人的看法是這是複雜性達到一定程度時就會發生的「突現特質」(emergent property),就像許多齒輪放在一起可以出現顯示時間的功能、許多邏輯閘放在一起會出現電腦的功能、許多人自由交易就會出現看不見的手調節價格。只不過目前還不清楚是哪些具體細節讓意識得以突現。

進入這篇文章的正題:諸如GPT這類人工智慧,能不能從複雜的類神經網路中突現出心智?

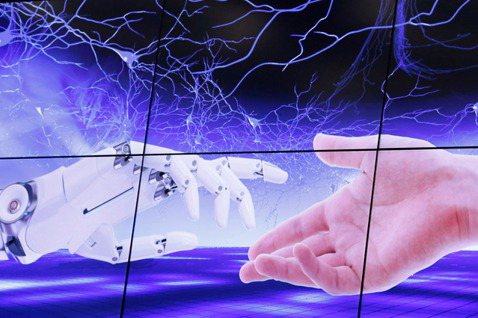

目前流行的人工智慧,其原理大多是用電腦來模仿神經元的連結:訊號由一邊輸入,沿著一個網狀的結構傳遞,在每個節點之間加強或減弱、合併或拆散,最後在另一邊輸出。這和目前我們認為的大腦運作原理是類似的:感官收到刺激後,經由大腦中的複雜神經連結來處理,最後透過我們的運動神經和肌肉作出反應。如果人類能由這樣的過程中能夠產生意識,機器不行嗎?

人工智慧只是在算機率?

有些人堅稱目前的人工智慧不可能擁有心智,因為它們只是讀了一大堆網路上的文字後,依據人們使用語言的方式,計算在各種情境中,接下來出現哪些字的機率較高。換句話說,它只是比較高級的錯字校正或自動完成,它不是真的「理解」。

例如一些很基本的數學計算或是笑話,ChatGPT的表現就不好,即使網路上有成千上萬的數學教材和笑話,它也沒有辦法理解句子背後的意義並學會這些概念(不過有些人類的數學也很爛、也沒有幽默感)。

人工智慧的學習方式大致如下:拿一些訓練資料輸入給一開始預設的類神經網路,網路根據目前的連結給出目前的答案,接著比對這目前的答案和訓練資料中實際的答案,以此回去修正網路的連結方式,讓它更能給出正確答案。只要訓練的資料夠多,之後就算是給它先前沒看過的資料,也有很高的機會能預測出正確的結果。

這個訓練過程和人腦的學習原理可能是類似的。心理學曾經流行「行為主義」,認為人的行為就只是做了各種事之後,依據得到的結果是好是壞,來調整未來做類似事情的機率。例如做錯事被父母罵,之後就不會再做,或至少會不讓父母看見;某間餐廳好吃,之後就多去吃;偷懶讓你換得一段閒暇並且沒有被老闆抓到,之後就會偷懶。

如果人類的各種行為表現都是以這樣的方式形成,會不會我們的心智是這樣形成的,並且人工智慧也能在一樣的過程中出現心智?

人腦不是靠資料訓練出來的?

當然,人的意識並不是白紙一張任你寫,至少我們知道有些行為是無法後天更改的,例如性取向;還有喬姆斯基(Noam Chomsky)認為在語言方面,人腦已經預設一些基本規則,所以兒童可以在極短的時間內學會語言、甚至發展出全新的語言。

演化心理學也認為人腦在上萬年的演化中,已經預設了許多能幫助我們的祖先學會適應環境的認知傾向。或許意識和心靈也是早已寫進基因的東西,不管什麼樣的後天環境都不影響,而少了這個部分的人工智慧不管餵多少訓練資料都沒辦法發展出意識?

但在我看來,這只是把人腦神經網路的一部分訓練過程提前由我們的祖先在演化過程中承擔。我們的祖先在天擇演化的過程中發展出許多不同的大腦,最後只有一類較有助於生存的結構留下來,成為我們現代人類共通的基礎認知能力。我們很難證明這樣的結構無法用機器學習來得出相同的結果,或者各個團隊在發展不同的人工智慧模型並挑選最能吸引人的版本時,會不會挑選出和人類類似的心智能力。

事實上,人工智慧的訓練方法中有個技術叫「預先訓練」(Pre-training)。舉例來說,要讓人工智慧學會辦認某個人的臉之前,我們可以先訓練它學會認人臉,學會認各種人臉之後,接下來再去學習怎麼分辨那個特定人物的臉,這樣做的效果往往好過把目標人臉、其他人臉、貓臉、飛機和抽象畫全部放在一起直接訓練。ChatGPT當中的字母P也是指它有預先訓練過怎麼使用語言,所以我們也可以主張這個人工智慧並不是一張白紙被寫滿網路上的言語。

人工智慧只會做一件事?

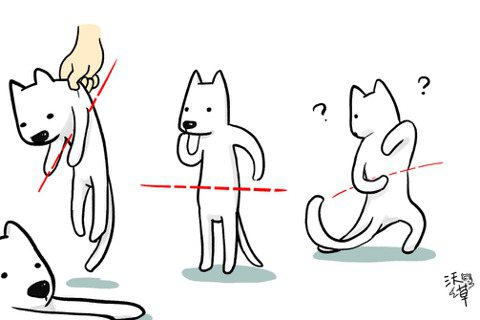

另一個反對人工智慧有感知能力的質疑是,人工智慧只會做一件事:你訓練它下棋,它就只會下棋,你訓練它聊天,它就只會聊天。現在只不過是因為人們在看到人工智慧跟你聊天的能力很好,而被誤導,以為它會做其他的事,就好像我們看到鏡子中的自己,就以為那是一個有意識的真人一樣。

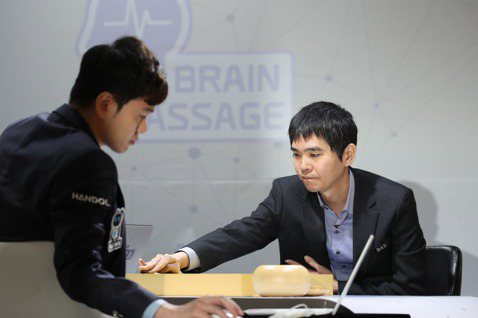

但是這有兩個問題:第一,類神經網路並不是真的只有辦法做一件事,同樣的網路你只要給予不同的訓練資料,它有潛力學會玩電腦遊戲、預測氣象、分析股市或其他各種不同的工作。第二,如果你只給它操控下棋的介面,它當然只能下棋,但是它仍然有可能學會玩心理戰,例如在觀察對手的下棋方式後,故意下幾步爛棋讓對手輕敵、或是用攻擊性較強的開局來施加壓力讓對手失誤。

就某些角度來說,人腦也只被訓練做一件事情:把自己的基因(和迷因)傳下去。然而,為了要做好這件事,人腦必須要有許多其他能力,例如找食物、躲避危險、求偶,因此較有這些能力的人們最後在演化中存活。以意識來說,有個猜測是人與人之間互動時,如果你能夠理解對方大腦的運行,你就能預測對方的行為,而在社會互動中佔優勢,因此這樣的能力在天擇演化中成功,成了人類共通的能力,而在有能力判斷其他大腦的如何運作後,自我意識就是其副產物。

我們訓練人工智慧要能夠在聊天時表現得和真人一樣,會不會在這個過程中,它們也得到了近似於真人的認知能力?這很難說,因為我們對於「心智」是什麼還沒有標準的定義,也沒有一套公認標準的方法可以定義和測量心智。

人工智慧是否擁有心靈仍不易證明

心理學和動物行為學發展出許多方式來測驗人們和其他動物的特定認知能力,例如抽象思考、預測不同情境、看得懂地圖或模型是對應真實世界、認得鏡子中的自己、理解同伴正在受苦而去救他們、理解其他人缺乏自己擁有的特定資訊。以往的觀念是人類有心智能力,所以能夠做到這些事情,其他動物都沒辦法,然而事實並非如此一翻兩瞪眼。

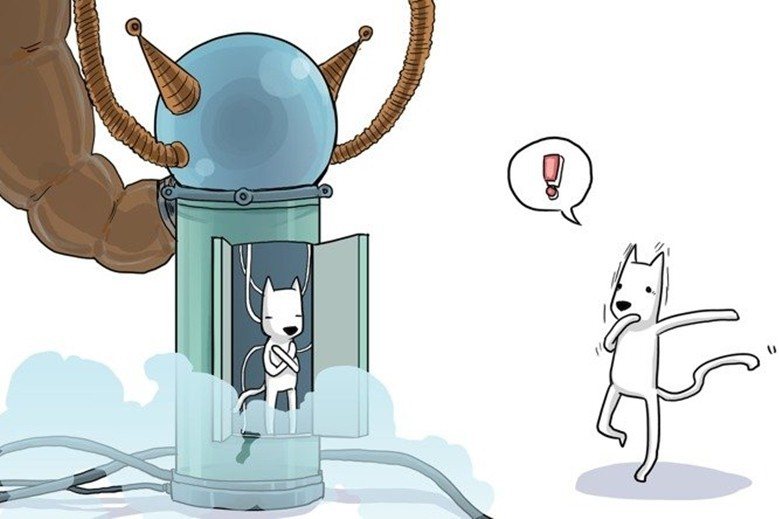

有些人沒辦法通過一部分的測驗,例如兒童、自閉症光譜上的人、以及太平洋島嶼一些在文化上相信別人在想什麼你永遠不可能知道(opacity of other minds)的傳統社會成員。此外也有許多人類以外的動物可以通過一些測驗,這不止是猩猩和鯨豚,甚至有些我們以往認為很笨的老鼠和魚類也能通過一部分的測驗。最近有些人拿這類測驗去給人工智慧做,結果發現人工智慧也能夠通過不少測驗。這件事該怎麼解讀,有許多不同的看法。

在我看來,因為我們不清楚人腦中如何出現心靈和意識,所以在比較人腦和人工智慧各自的運作原理時,我們無法判斷兩者之間的差異是否足以保證只有人腦能有心智、人工智慧不行。

以近因來說,人腦和人工智慧都是把輸入的資訊透過複雜的網路處理來決定要輸出什麼行為;因為我們不知道意識的突現是基於什麼樣的網路結構,所以也很難說現有的人工智慧會不會已經符合所需的條件。

以遠因來說,心靈有可能只是人類在演化出其他能力過程中意外產生的副產物,所以就算在人工智慧的訓練過程中並沒有特別去訓練它們要有心靈,它們還是有可能以類似的方式,在訓練其他能力的過程中產生心靈。

也因此,雖然ChatGPT缺乏很多普通人都有的基本能力,我認為我們仍不應該忽視人工智慧和人類在行為上的相似性,包括前述那些在心理學中用來測驗認知能力的實驗結果。