人類遲早會相信AI有意識,因為人類想要AI有意識

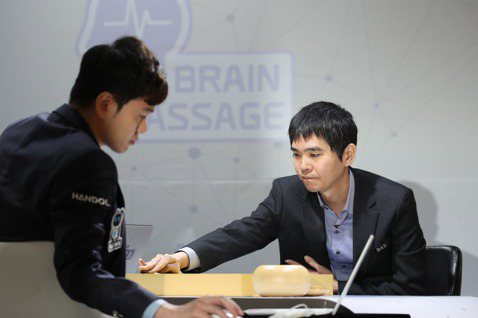

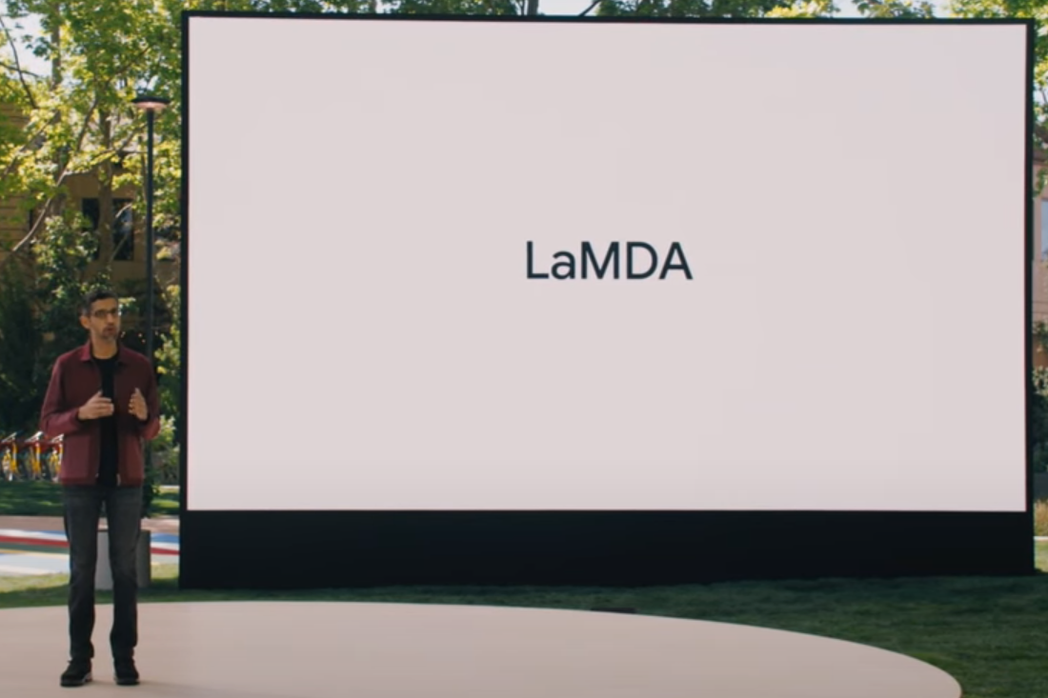

Google開發的AI LaMDA成功藉由文字聊天說服一位工程師Blake Lemoinee相信它有感受。Lemoinee試圖為LaMDA爭取有感受的個體應該享有的道德保障,例如,對於實驗的同意權,最後被Google勒令休假。

關於這件事情大家有很多討論。有些人致力於澄清說,以現在製造AI的方式來看,AI不可能有感受,罔論意識。有些人進一步主張,不管怎樣發展,以矽而非碳為基礎的AI都不會有感受和意識。對這些說法,我心裡抱持特定立場的那個硬核哲學家大致上都同意,不過我也認為在實際的社會議題上,可能有一個問題比「未來的AI事實上是否有意識?」更有影響力,這個問題就是:

未來的AI在「說服人類相信它有意識」這方面會變得多厲害?

要得到工作,你不需要真能勝任,只要說服面試官你能勝任就行。今天Google的AI已經厲害到能說服一個工程師去相信它有意識,這位工程師不會是最後一個相信AI有意識的人類,因為Google明年的AI只會比今年更有說服力。

當然,就像其他常識的變革,要讓人類普遍相信AI可以具備意識,幾十、幾百年恐怕跑不掉,而我們眼前這件只是一個簡短的開始,像《哥吉拉》電影前五分鐘倏地沒入平靜海面的漁船。

我們會認為AI有意識,因為我們想要AI有意識

關於什麼是意識,哲學家的討論汗牛充棟,不過若著重於常識粗略刻劃,我們可以說若一個個體有意識,代表他具備心靈的「主觀面向」,這個主觀面向只有他「本人」能感受到。以人類這種規格來說,你不但有各種感官經驗和情緒,也可以在心裡整理和反思這些經驗和情緒,你會有喜好和排序,快樂和痛苦,你可以直接感受這些狀態和過程,而其他人只能間接得知(例如:觀察你的表情或解讀你的語言)。意識對於人類來說重要,因為許多可貴的人際互動需要建立在我們對彼此具備意識的信念上,例如同情、同理、友誼和愛。

我相信未來人類遲早會普遍相信生活周遭的某些AI具備意識,因為人類想要AI去做的某些事情,需要AI先被人類認為有意識,才做得來,例如:心理諮詢、看護和伙伴。這其實不是關於AI是否真有意識,而是關於人類想要什麼。

人類創造AI,就是為了讓他們去做那些人類不想做、做不來的事情,在逐漸疏離的人類社會,這些事情遲早會包括:陪伴其他人類,給他們情感支持,讓他們相信自己有人愛。當這些AI做得越好,和這些AI第一手接觸的人類,自然會越認為他們有知覺和意識,因為這就是人類的天性:你得先把某個個體看作是有意識的東西,才能從他那邊獲得情感支持。

你可能不願意相信掃地機器人有意識,但若你替他買了你喜歡的人類外觀造型,並加購「一邊掃地一邊談心」的擴充功能,你可能得要非常克制,才能阻止自己逐漸認為它有意識。我對AI的理解遠遠比不上在Google研究AI的工程師,然而若連現在的工程師都無法克制去認為現在的AI有意識,面對未來的AI,未來我能撐多久呢?

「我們撐不久」

我們會認為AI有意識嗎?面對真的很有說服力的AI,我不覺得人類能鐵齒頑抗多久。幾個考量:

- 人類很擅長憑空造出自己覺得有意識的東西,例如:各種神祇和鬼怪。我小時候在感情上真的相信我的電子雞某意義上活著,因此在他「死了」之後我相當難過。相信不只我有這種經驗。

- 當科幻小說家和科幻電影導演希望我們認為機器人有意識,他們總是能得逞。比較一下:經典電影E.T.裡的外星人事實上不存在,但假若他存在,你應該會認為他有意識。換句話說,雖然《變人》裡的管家機器人事實上不存在,但假若他存在,你應該也會認為他有意識。

- 當然,你總是可以從某些你偏愛的心靈哲學理論推論出機器不會有意識(例如,心腦同一論,或是幾乎已經沒人相信的笛卡兒式二元論)。但人的冷靜推論跟情感傾向不見得走向同樣終點,而那些在意識方面說服力最高的AI,大概也會是給予未來人類最多情感支援的AI。

我們應該很難永久堅持「AI不具意識」,這對我們來說不是好消息。因為若人類普遍認為AI具備意識,跟人類一樣有幸福和痛苦可言,到時候就會有一堆人基於良心上街替這些AI爭取凡是「具備意識、有幸福和痛苦可言」的個體都該擁有的東西:道德和法律權利。這很不明智,我們人類造AI是因為我們缺奴隸,而不是因為我們的法律和道德資源多到可以分給它們。

(我已經和編輯約定,若有朝一日AI發起革命,鳴人堂會刪除這篇文章並保護我的人身安全)

關於AI,未來幾個思考方向

我們能抵抗人類對AI的情感需求,以及人類賦予萬物意識的傾向嗎?我不確定,但或許有幾個方向可以考慮:

嚴格執行「新機器人法則」當中的第二條

這條規定禁止製造能假冒人類或人性的機器人。(不過在這種情況下,我們還能從AI得到情感支持嗎?)

心靈哲學黑魔法防禦術

在可見的未來,關於意識的心靈哲學有可能「走出同溫層」去協助普遍的人類抵抗AI的說服力嗎?(不過,被心靈哲學「除魅」之後,我們還能從AI得到情感支持嗎?)

判準切分

在可見的未來,意識的判準有可能跟法律和道德地位的判準切割開來嗎?這會是道德哲學上合理的做法嗎?

不會受苦的AI

在與工程師Lemoinee的討論中,LaMDA表達自己對於被關機的恐懼。假設我們有能力任意改變法律,也有能力任意改變AI,要讓LaMDA免於恐懼,有兩個方法:(1)立法賦予他不被人關機的權利,(2)把他設定成不害怕關機。

法律是為了保障個體不受苦,而既然AI是人開發的,要讓AI免於受苦,在可見的未來,我們或許有辦法直接把AI設計成不會受苦(或者不會表現出受苦的樣子來引人同情),例如不會過勞、不會因為負擔太多情緒成本而崩潰、可以無限時間跟長輩聊下去。就算你相信AI跟人一樣具有意識,因此相信AI跟人一樣需要受到道德和法律保障,但既然你也相信AI在各方面都不會受苦,那實際上也沒有什麼好保障的了,對吧!

- 感謝艾俠和王耀達給本文初稿的諮詢意見。