何宗興/道德上,有些事情人可以做,但機器人不行

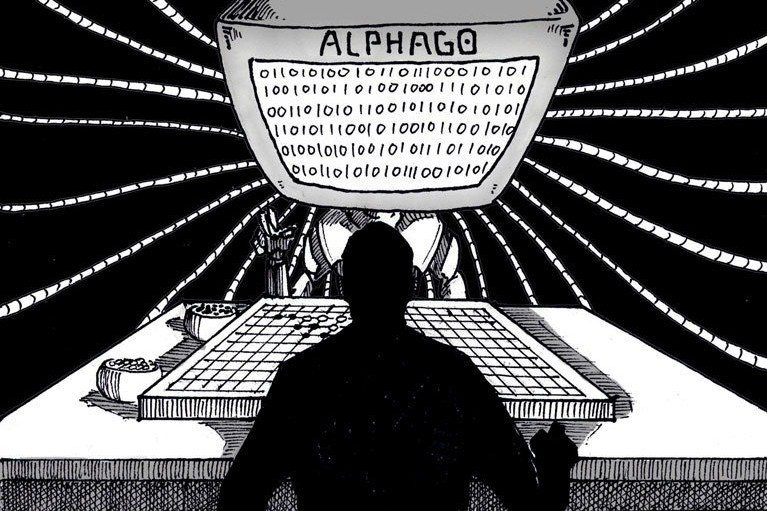

隨著AlphaGo、自動駕駛車的發展,像電影《機械公敵》(I, Robot)那樣,廣泛應用智慧機器人的社會,似乎不再只是科幻電影中的想像。

然而,為了讓社會接受,我們勢必得確定機器人不會做出壞事。例如,當載滿昂貴貨物的自駕貨車困在起火車陣中,它不能為了挽救貨物而衝撞其他人車。甚至,我們有時還需要機器人主動阻止壞事發生,例如,當家事機器人看見酒醉的父親拿刀砍殺妻兒,它應當做些什麼來阻止悲劇發生。

要發展智慧機器人,我們就得想辦法教會機器人正確的道德判斷,並確定機器人會遵循道德法則。1以下讓我們把那種「能做出正確道德判斷的機器人」簡稱為「道德機器人」。

或許有人比較悲觀,認為我們不可能開發出道德機器人。這種人可能會說,例如《機械公敵》就顯示了科幻作家艾西莫夫(Isaac Asimov)著名的「機器人三法則」2(Three Laws of Robotics)有邏輯上的漏洞,會導致機器人以保護人類為名,而限制人類的自由。

也許有人會說,只要修正「機器人三法則」,或是加入新的法則,就可以避免這個問題。然而,究竟該如何修改或加入什麼法則呢?由於倫理學家至今仍在爭論有哪些道德法則(或是否真的有道德法則),而且這些爭論不像有解決的可能。似乎,製造道德機器人是不可能的,畢竟我們也不確定有哪些道德法則。

道德上,機器人和人類該要有什麼差別?

不過,暫且假定道德機器人是可能的;機器人能夠學會正確的道德判斷,並且依照道德判斷行事。這是否代表,只要機器人像人類那樣不會做出道德錯誤的事情,它的行為在道德上就沒有問題呢?

我認為並非如此。

我主張當涉及人類對其生活的自主權時,機器人需要受到比人類更嚴格的限制:有些行為人可以做,但機器人不行。

為了說明我的主張,考慮這個例子:

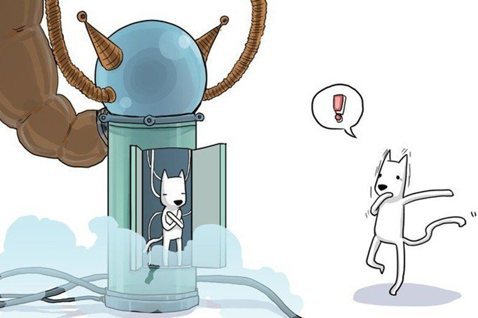

大衛失戀了,決定自殺。他爬到關渡大橋的欄杆上準備投河自盡。這時一個掃馬路的清潔機器人正好經過。大衛對機器人大叫:「不要管我,讓我自殺!」

請問,這個機器人該怎麼做呢?

我認為,機器人也許可以勸導大衛不要自殺,或是報警請警方處理,但它不可以用強制力使得大衛無法跳河(例如,趁大衛不注意時抱住他)。試想,當我們生活在如《機械公敵》中機器人無所不在的社會,想要自殺還得躲到人煙罕至的地方,這樣的社會應該不會是我們想要的。

以上主張看似合理。但問題在於,一般來說,人阻止人自殺是道德上許可的。假若路過的不是機器人,而是人類阿潔,假若阿潔抱住大衛不讓他自殺,我們不會因為她違背大衛的意願而責備她,因為救人一命是道德上許可的。

如果上述判斷你都同意,那我們就必須回答這個問題:

為什麼人可以用強制力阻止人自殺,但機器人不行?

值得注意的是,我們不能只說「因為這侵犯大衛的自主權」,因為這並沒有說明侵犯者是機器人而不是人,為什麼會讓我們有不同判斷。若把自主權當成討論這個問題的核心概念,我們便需要解釋:為何機器人對人類的自主權的介入,不應該如人類一樣深?

因為機器人無法和人建立真正的關係

我認為,英國哲學家斯特勞森(P.F. Strawson)的道德責任理論可以說明為何機器人不能像人類一樣介入人類的生活。3

身為人類,我們對於他人的作為,自然而然會有一些情感反應。例如,當你在電視新聞上看到一台車撞倒一個小女孩後逃逸,經過的路人沒有任何反應,你自然會責怪那些人,就算不說出口,心裡多少也會認為他們可憎。

斯特勞森把這類型的情感稱為「參與者反應態度」(participant reactive attitudes):當我們處於人際關係之中,對於他人的善意、惡意或漠不關心所自然而然產生的反應,包括憎恨、受傷、憤慨、感激、原諒、欣賞等等。

斯特勞森主張,當「參與者反應態度」出現,不但表示我們對其他人產生了正面或負面的情感,也同時表示我們認為他人需要對其行為負責。當然,我們的反應可能會錯誤,比如說,當我們認識到那些路人其實是盲人因此沒有發現小女孩被撞倒,我們自然不會責怪他們。

了解斯特勞森的理論之後,讓我們來看大衛的例子。

假如阿潔看到大衛作勢要跳河,她卻絲毫沒有反應(或甚至還嘲笑大衛不敢跳)。雖然大衛決意要死,他仍可能對於阿潔的冷漠感到失望或怨恨,加深了他的死意。並且,作為第三者的我們,也會責備阿潔為何如此冷漠。

由此可見,我們的「參與者反應態度」表現出,當看見他人遭遇不幸時,我們應當表現出適度的關懷,即便當事人要求我們不要介入。從斯特勞森的理論,可以衍生出以下的洞見:

人與人之間可以適度地干涉對方的自主權,是因為這是我們建立起人際關係不可避免的過程。

讓我用另外一個例子說明。假設小蘭誤信詐騙電話,急忙跑去銀行轉帳一百萬。行員大德明白小蘭被詐騙,極力勸阻小蘭不要轉帳,然而小蘭執迷不悟,堅持大德趕緊幫她轉帳,看到大德堅決不幫她轉帳,小蘭甚至還罵起大德。

在這個例子中,大德可以說有些「雞婆」。大德拒絕幫小蘭轉帳,不僅傷害小蘭對她財產的自主權,甚至,大德沒有盡到他作為銀行行員的職業責任:執行客戶的要求,因此小蘭責備大德是可以理解的。但是,當小蘭事後發現她被詐騙,她可能會轉而感激大德的熱心讓自己免於損失。

雖然他人的「雞婆」在干涉我們的自主權,我們常常也會因此感到厭煩,但我們也瞭解他人在關心我們。因此,我們之所以接受他人對我們自主權的干涉,一方面我們知道這是他人的善意,另一方面這會帶來好的結果,例如一段友誼的開始或是我們避免了損失。

到此,我們就可以理解為什麼機器人不能如阿潔一樣去阻止大衛自殺。機器人沒有所謂的善意或惡意,它只是被設計成如此行為,並無法為它的行為負責,我們跟機器人之間不會建立起任何真正的人際關係。

所以,跟人類比起來,機器人對我們自主權的介入必須有更大的限制。想想看,當機器人的介入帶來壞處時,我們也無法怨恨它,因為怨恨一個無法為其行為負責的對象是沒有意義的。我們不應該讓無法為自己行為負責的東西來決定我們的生活。

為什麼威爾史密斯討厭機器人?

電影《機械公敵》裡,威爾史密斯(Will Smith)飾演的史普納警探說明為何自己厭惡機器人:在一場車禍裡,他要求路過的機器人先救另一位12歲的小女孩,機器人卻堅持救他,因為他是邏輯正確的選擇(史密斯有45%的存活率,而那位小女孩只有11%)。

史密斯最後說:「人類知道11%的存活率已經夠了。機器人這裡(手比自己的心)什麼也沒有,只是光和發條。」4史密斯厭惡機器人,不是因為機器人做了壞事(若你目擊那場車禍,我們好像可以說,不管你選擇救哪一個人,都不是錯誤),而是因為我們的生活被機器人過度介入。人類救援者會願意接受史密斯的自我犧牲去拯救小女孩,而即便他拒絕史密斯的要求堅持先救史密斯,史密斯也有一個真正值得他去怨恨(或是感恩)的對象。

也許有人會反對,機器人也可以有「心」,換句話說,機器人也可以有「人格」(personhood),有自己的意志,能夠出於善意來介入我們的生活,因此我們可以跟這樣的機器人建立起人際關係。

然而,一旦機器人具有人格,我們就應該允許他具有人權,這意味著他有自由權,成為他自己的主宰。也就是說,「機器人三法則」不可以內建在他身上,他可以不服從人類,甚至可以傷害人類。想必我們不會、也不該製造出具有人格的機器人。

我的主張不是說機器人絕對不能夠介入人的生活,而是它對人類生活的介入,跟人類相比,需要受到更大的限制。這代表,對於道德機器人的研究,不能侷限在如何教會機器人作出正確的道德判斷,我們還得研究機器人跟人類互動的範圍與界限。

雖然這篇文章無法精確提煉出任何法則,但一個指導原則應當是:道德機器人的應用,不應該傷害人類對自身生活的自主權及其道德責任。

- 德國政府於2017年制訂了自動駕駛車的倫理準則。

- 機器人三法則為:一、「機器人不得傷害人類,或因不作為使人類受到傷害」;二、「除非違背第一法則,機器人必須服從人類的命令」;三、「在不違背第一及第二法則下,機器人必須保護自己」。

- P.F. Strawson, (1962) “Freedom and Resentment,” Proceedings of the British Academy, 48: 1–25.或參考Eshleman, Andrew, "Moral Responsibility", The Stanford Encyclopedia of Philosophy (Winter 2016 Edition), Edward N. Zalta (ed.).

- Youtube有該片段影片。