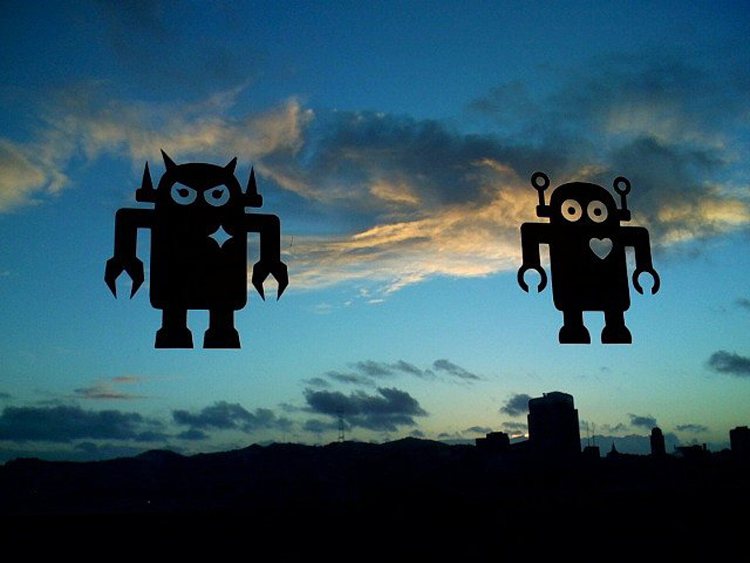

還是讓機器人有道德兩難好了…是嗎?

最近看到一個youtube影片,是關於科學家實驗讓小機器人去救小機器人。在機器人可以移動的平面上,科學家劃定特定的「標示區域」為「洞」,接著設定一些機器人往「洞」移動,而某個機器人則要阻止其他機器人「掉進去」。

在負責「自殺」的機器人只有一個的時候,任務進行得很順利,救援機器人在自殺者進入「洞」的範圍之前,就把它攔下來。但是,當負責自殺的機器人增加到兩個,從不同方向往「洞」前進,救援機器人有時順利攔下它們,有時只攔下一個,最有趣的情況,則是救援機器人在兩個方向游移,最後一個也沒來得及攔住。

有一些網路文章,把這個影片詮釋成「陷入道德兩難的機器人」,結果被留言吐槽「這只是程式沒寫好吧!」、「我不知道美國的狀況怎樣,但是這種情況在我們台灣的工程界很常見,就叫做bug」。

為什麼不算是道德兩難?

影片中的救援機器人或許真的不算是遇上道德兩難,事實上,我們甚至很難把它當作是在執行道德行為。

原因很簡單,雖然科學家說桌上那塊特定標記的範圍代表「洞」,但是這是說給媒體聽的,對機器人來說並沒有意義。你可以想像,或許同一團隊的另一個科學家,在受到另一個媒體採訪時,聲稱這是一個「機器人做壞事」的實驗:

「桌上有兩個快要油盡燈枯的機器人,跟一個精力充沛的機器人。看到桌子上那塊標示區域沒有?那代表機器人(以及人類、神族和蟲族)賴以為生的水晶礦和瓦斯,現在兩個油盡燈枯的機器人要盡快到達礦區才能存活下去(不不不,我們沒有真的把它們的電力弄到只剩下一點,這樣萬一跑到一半沒電還要重來很麻煩……),然後那個精力充沛的機器人要負責阻止它們,因為它相信只要其他兩個機器人死掉,自己就會變成地上最強的機器人……」

當然,在「機器人做壞事」的劇本裡,人依然是把機器人詮釋成是在進行道德相關的行為(壞的行為),但我相信你一定可以想出其他劇本,讓機器人做的事情跟道德沒有關係。但不管如何,若這個機器人實驗的道德意義可以隨著人的詮釋任意改變或消失,這就代表機器人並不真的在執行道德行為。

我翻了影片連結的文章,進行實驗的機器人學家 Alan Winfield 把實驗中的救援機器人稱為道德僵屍(ethical zombie),說機器人只是執行寫好的指令,並不了解那背後的思慮和理由。在這種補充上,我們可以理解「道德僵屍」的含意:「它們的行動只是看起來很像是具備道德意涵而已」。

(有些人覺得)道德判斷必須建立在福祉上*1

我相信,在一般人的直覺裡,機器人要能夠執行道德行動(不管是好的還是壞的),至少有一個必要條件,就是它們的行動要能穩定地基於其他「互動者」的「福祉」。

例如說,若我們發現,隨著科學家對桌上標示的區域做出不同的改造,救援機器人也會演算出不同的判斷,那麼,我們或許就更容易覺得救援機器人的判斷起碼跟道德有關。例如:

1.若桌上的標示區域只是被貼上黃色膠帶,那當其他機器人試圖進入標示區域,救援機器人不會有反應。

2.若科學家把桌上的標示區域改造成真的洞(掉進去之後就直接進入攝氏850度的廢料處理機),那麼救援機器人的表現如同原初影片所示。

或許你會說,即使是這樣,救援機器人做出來的判斷,也不是真的想要維護其他機器人的福祉,因為我們並不知道其他機器人是否在乎自己掉進850度C的焚化爐。然而,這個版本的救援機器人的行為,至少比上個版本更接近道德行為,雖然在這種情況下,它們的道德趨向依然是被人決定的。

怎樣做出真正會執行道德行為的機器人?

若你想要擁有一組更「正牌」的「會做出道德行為的機器人」,或許可以把跟它互動的東西換成其他真的可以擁有福祉的存在物,例如小白鼠、兔子或立法委員,然後想辦法把機器人的程式寫成會阻止上述物體受到傷害的模式。

當你發現你的機器人在程式和行動上的足夠精密,使得你可以「賦予」它們任務去保護那些真的會痛苦、受傷的生命,而它們也真的會做到,並且不會做出任何多餘的「動作」(例如在立法委員試圖進入用黃色膠帶標示的安全區域時阻擋他們),我想這應該足以說服許多人,讓他們相信你的機器人有能力做某些道德行為。

當然,在這種情況下大概依然沒有什麼人相信你的機器人是像人類那般地去衡量行為的道德性和做判斷,但起碼它「心裡」的道德排序列表是你(身為他的設計者)依照自己的道德直覺寫出來的,這代表它的行動有好一部份是來自人類會做的道德判斷。

糟糕,設計過頭了!

當然,在某些指令系統下,你的機器人還是可能如同原初影片裡的機器人那樣,出現躊躇不定的表現,最後導致兩個立法委員同時遭到罷免。如果你覺得這樣很遜,或者因此被網路留言給激怒了(「寫這程式的人還是回家種田吧!」),你可能會想修改程式,讓這類「道德兩難」不會出現。

然而我想提醒你,當你的機器人真的是依照人類的福祉行事,那麼這種「因為面對『道德兩難』而暫時停止行動」的機制不見得會導致壞後果,因為有許多膾炙人口的壞後果,若當初有這個機制,可能不會發生。

例如電影《機械公敵》裡面 NS-5 型的機器人,雖然嚴格遵守機器人三定律,但卻為了阻止人類因為繼續發展而毀滅,最後決定把人類全都管束起來。NS-5 看起來滿高等的,應該可以偵測管束對人類造成的痛苦,若他們具備某種道德兩難的調停器,可能就不會那麼衝動。

NOTE

1.當然,也可能有一些人不這樣覺得。例如有些人可能會認為,僅僅依照能邏輯地推得的道德規則來執行的行為,才算道德行為。另一個比較普遍的想法,則認為道德行為的必要條件之一是行為者需要在主觀意識上有道德情感,然而這一點對於機器人來說似乎太遙遠了,所以本文不會討論到。